生成式 AI 作为当下最炙手可热的人工智能形式,正为诸如 ChatGPT、Ernie、LLaMA、Claude 和 Command 等聊天机器人,以及 DALL-E 2、Stable Diffusion、Adobe Firefly 和 Midjourney 等图像生成器提供源源不断的动力。生成式人工智能,作为人工智能的一个分支,赋予机器从海量数据集中学习模式,进而自主生成全新内容的能力。尽管这一领域尚属新兴,但已涌现出众多可生成文本、图像、视频和音频的模型实例。

许多“基础模型”经过大量数据的训练,已能够胜任多样化任务。以大型语言模型为例,它能够生成论文、计算机代码、食谱、蛋白质结构、笑话,甚至医疗诊断建议等。理论上,它还能生成制造炸弹或生物武器的指令,但得益于安全措施,此类滥用行为得以有效遏制。

那么,人工智能、机器学习和生成式人工智能之间究竟有何区别?

人工智能(AI)是一个广泛的概念,涵盖了模仿人类智能的各种计算方法。机器学习(ML)则是人工智能的一个重要子集,专注于研发使系统能从数据中学习并优化性能的算法。在生成式人工智能兴起之前,大多数机器学习模型主要聚焦于通过学习数据集来执行分类或预测等任务。而生成式人工智能作为机器学习的一种特殊类型,其涉及的模型能够执行生成新内容的任务,进而涉足创造力领域。

生成式人工智能模型使用哪些架构?

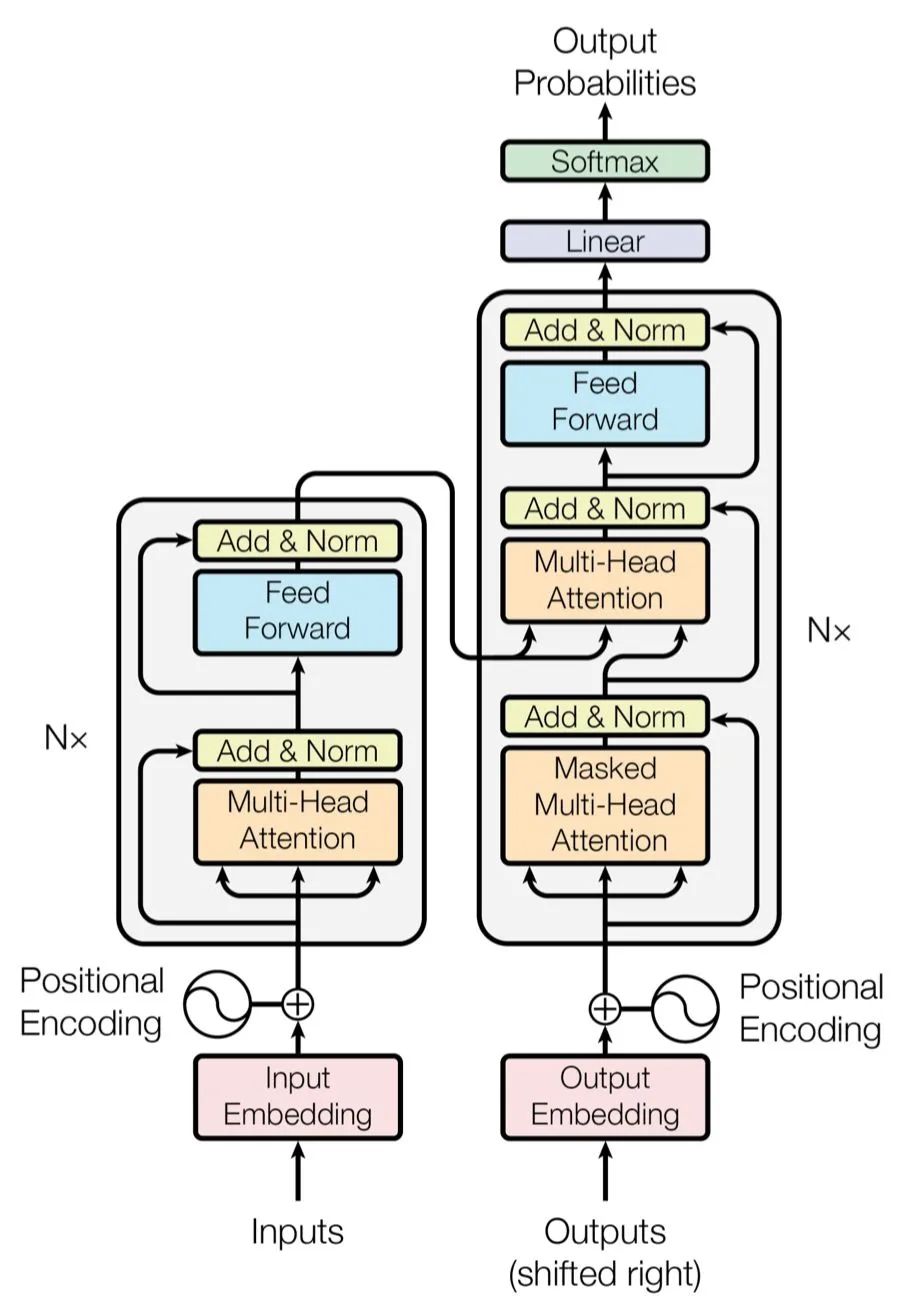

生成模型是利用多种神经网络架构构建的,其核心在于定义模型的组织方式以及信息在模型中的流动路径。其中,变分自动编码器(VAE)、生成对抗网络(GAN)和 Transformer 等架构最为著名。谷歌在 2017 年发表的开创性论文中首次展示的 Transformer 架构,为当今的大型语言模型提供了强大的动力。然而,对于图像和音频等其他类型的生成人工智能,Transformer 架构并非最佳选择。

自动编码器通过编码器-解码器框架学习数据的有效表示。编码器将输入数据压缩至低维空间,即潜在(或嵌入)空间,保留数据最本质的特征。随后,解码器利用这一压缩表示重建原始数据。一旦自动编码器以这种方式完成训练,它便能利用新颖的输入生成合适的输出。这些模型常用于图像生成工具,并在药物发现领域发挥重要作用,能够生成具备所需特性的新分子。

生成对抗网络(GAN)的训练涉及两个相互对抗的组件:生成器和判别器。生成器的目标是创建逼真的数据,而判别器则致力于区分生成的输出与真实的“地面实况”输出。每当判别器识别出生成的输出时,生成器便利用这一反馈提升其输出质量。同时,判别器也会收到关于其性能的反馈。这种对抗性的相互作用促使两个组件不断完善,进而生成愈发真实的内容。GAN虽以创建深度伪造品而闻名,但同样可用于更良性的图像生成形式和其他多种应用。

可以说,Transformer 是生成式 AI 架构的佼佼者,它在当今强大的大语言模型(LLM)中占据核心地位。其优势在于独特的注意力机制,使模型在预测时能够关注输入序列的不同部分。在语言模型的应用中,输入由构成句子的单词序列组成,Transformer 能够预测接下来可能出现的单词(我们将在下文详细介绍)。此外,Transformer 能够并行处理序列中的所有元素,而非像早期模型那样逐序遍历;这种并行化处理方式显著提升了训练的速度和效率。当开发人员将大量文本数据集供 Transformer 模型学习时,便诞生了当今卓越的聊天机器人。

大型语言模型如何工作?

基于 Transformer 的大型语言模型(LLM)是通过向其提供大量文本数据集进行训练的。其中的注意力机制在处理句子和探寻模式时扮演着关键角色。通过同时审视句子中的所有单词,它逐渐认识到哪些单词经常共现,以及哪些单词对句子的意义至关重要。模型通过尝试预测句子中的下一个单词,并将其预测与实际情况进行比较,从而学习这些规律。其预测错误会作为反馈信号,促使模型在下次尝试前调整分配给各个单词的权重。

为了更专业地解释训练过程,训练数据中的文本会被分解为称为标记的元素,这些元素可以是单词或单词片段。为简化说明,我们假设所有标记均为单词。当模型遍历训练数据中的句子并学习标记间的关系时,它会为每个标记生成一个数字列表,即向量。这些向量中的数字代表了单词的多个维度:其语义、与其他单词的关系、使用频率等。语义相近的词,如“优雅”和“奇特”,将拥有相似的向量,并在向量空间中彼此靠近。这些向量被称作词嵌入。LLM 的参数涵盖了所有词嵌入和注意力机制相关的权重。GPT-4 作为 OpenAI 的杰出模型,据传拥有超过 1 万亿个参数,堪称当前的领军者。

在拥有充足的数据和训练时间后,LLM 开始掌握语言的微妙之处。尽管大部分训练涉及逐句分析文本,但注意力机制还能捕捉多个段落较长文本序列中单词间的联系。当 LLM 经过训练并准备就绪时,注意力机制依然发挥着作用。模型在根据提示生成文本时,会利用其预测能力来确定下一个单词。在生成长篇文本时,它会在已编写单词的上下文中预测下一个单词,从而增强了文本的连贯性和流畅性。

为什么大型语言模型会“产生幻觉”?

您可能听说过大型语言模型有时会“产生幻觉”。这实际上是一种委婉的说法,指的是模型生成的内容虽然极具说服力,但却与事实不符。

这些模型有时会产出语法正确且适应上下文的文本,但其中的内容可能是错误或毫无意义的。这种不良倾向源于模型在训练过程中接触了大量从互联网上获取的数据,其中不乏不准确的信息。由于模型的主要任务是基于已有内容预测序列中的下一个单词,因此它可能会生成听起来合理但缺乏现实依据的文本。

为什么生成式人工智能存在争议?

生成式人工智能的争议之一源于其训练数据的来源。众多致力于训练大型模型以生成文本、图像、视频和音频的人工智能公司对其训练数据集的内容并不透明。根据各种泄露和实验,这些数据集包含了受版权保护的材料,如书籍、报纸文章和电影。目前,许多诉讼正致力于确定使用受版权保护的材料训练人工智能系统是否构成合理使用,以及人工智能公司是否需要向版权所有者支付费用。

此外,人们普遍担忧生成式人工智能的广泛应用可能会威胁到从事艺术、音乐、书面作品等创作的创造性人类的就业。同时,也有忧虑它可能取代从事各种白领工作的人,包括翻译、律师助理、客户服务代表和记者。尽管已有一些裁员事件,但生成式人工智能是否足够可靠以支持大规模企业应用程序尚难定论。

最后,生成式人工智能还存在被用于制造不良内容的潜在风险。理论上,它可用于进行个性化诈骗和网络钓鱼攻击,例如使用“语音克隆”技术复制特定人的声音进行诈骗。所有格式的生成式人工智能,包括文本、音频、图像和视频,都有可能通过创造看似真实的虚假信息来误导公众。尽管主流公司的工具禁止此类使用,图像和视频生成工具也可能被用于制作未经同意的色情内容。大型模型都有防止滥用的措施,但黑客仍可能规避这些保障,且开源模型的“未经审查”版本已经存在。

尽管存在这些潜在问题,许多人认为生成式人工智能也能够提升人们的生产力,并成为实现全新形式创造力的工具。我们可能会见证灾难与创意并存的时代,以及许多意料之外的事物。因此,了解这些模型的工作原理的基础知识对于当今精通技术的人来说愈发重要。无论这些系统变得多么复杂,人类的任务是确保它们的正常运行,推动下一个系统的进步,并在可能的情况下帮助人们解决问题。