在 2025 年台北国际电脑展(COMPUTEX 2025)上,英伟达(Nvidia)CEO 黄仁勋发表主题演讲,宣布推出 NVLink Fusion,这一举措将英伟达已在自家 AI 生态系统中广泛应用的 NVLink 高速互联技术,扩展到了更广阔的领域。

NVLink 是英伟达开发并用于自家数据中心产品的高速互连技术,在 AI 数据处理中扮演着极为关键的角色。

通过 NVLink,多个 GPU 能够链接在一起,形成强大的计算集群,宛如将多个 GPU 融合为 “一个” 大型 GPU ,或者成为一个无瓶颈的大型 AI 加速器,极大提升数据处理效率。

NVLink 5 作为最新一代产品,性能十分强劲,单向数据速率可达 900GB/s,双向数据速率更是高达 1800GB/s,传输速率为 100GT/s,由 18 个 NVLink 组成,每个 NVLink 带宽为 50GB/s 。

自 Blackwell 架构开始,NVLink 5 便投入使用,并且 Grace CPU 也能够与之连接。不过,在这之前,NVLink 互连技术仅用于英伟达自己的解决方案,比如 GPU 与 GPU(Blackwell 到 Blackwell)的连接,或者 CPU 与 GPU(Grace 到 Blackwell)的连接。从 Blackwell 开始,在一个域内,多达 576 个 GPU 可通过 NVLink 5 交换机实现直接连接,彼此协同工作。

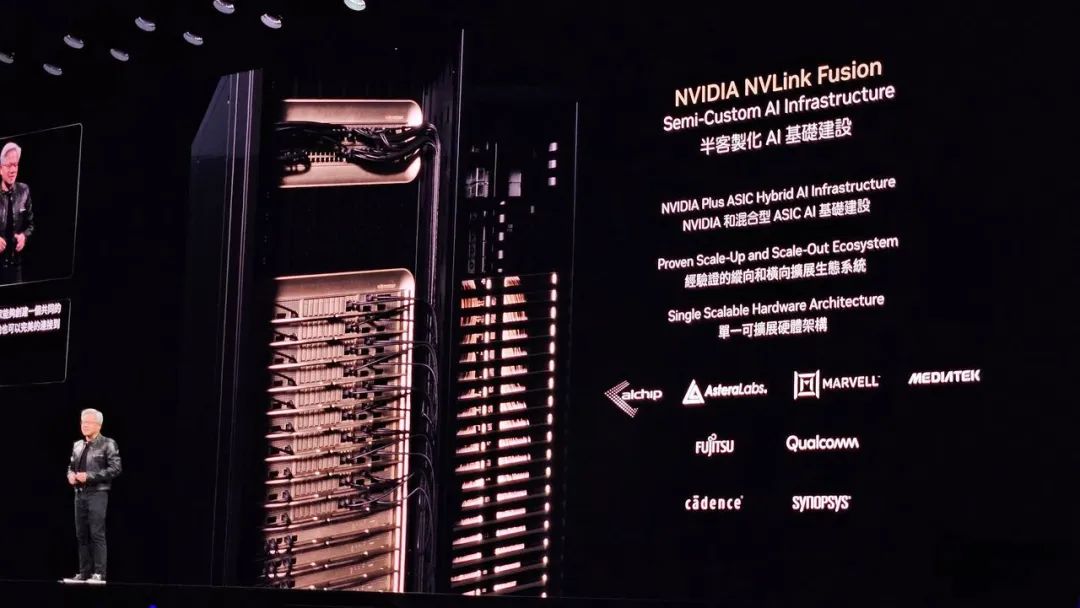

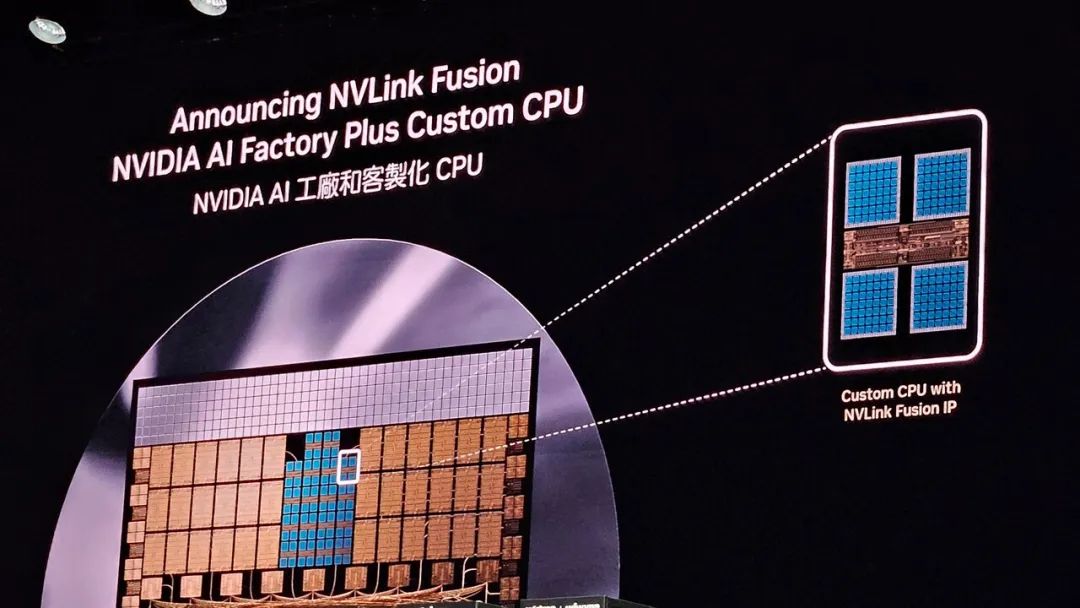

而如今推出的 NVLink Fusion,意味着客户可构建英伟达与第三方结合的半定制混合 AI 基础设施。搭载 NVLink Fusion IP 的 ASIC、CPU、加速器,都能与英伟达第一方硬件无缝通信。

这一技术的开放,让定制 ASIC 和定制 CPU 在 AI 数据中心中,与英伟达硬件结合使用成为可能。但英伟达并非毫无保留地开放技术,为确保自身在 GPU 或 CPU 产品领域的参与度,有两个重要因素需要考量:其一,在组合使用上有所限制。具体而言,英伟达允许的组合方式为,带有 NVLink Fusion 的定制第三方 CPU 可与 Blackwell GPU 搭配,带有 NVLink Fusion 的第三方定制 AI 加速器(ASIC)能与 Grace CPU 结合。但第三方 CPU 无法通过 NVLink Fusion 连接到第三方 ASIC,即 NVLink 的使用必须有英伟达产品参与其中,以保证英伟达始终是最终系统的一部分,无论是凭借自家的 GPU 还是 CPU。

在发布 NVLink Fusion 时,英伟达公布了强大的合作伙伴阵容。在 AI 加速器定制芯片领域,合作伙伴有 Alchip、AsteraLabs、Marvell 以及 MediaTek(联发科) 。

CPU 合作伙伴方面,富士通和高通参与到定制 Arm 处理器的开发中。在芯片开发和生产准备环节,技术合作伙伴 Cadence 和 Synopsys 也加入进来。高通拥有自家 CPU,此次参与 NVLink Fusion 项目,也进一步证实了其重返数据中心领域的决心。

黄仁勋表示:“几十年来,数据中心首次必须从根本上进行重构 – AI 正在融入每个计算平台。NVLink Fusion 开放了英伟达的 AI 平台和丰富的生态系统,让合作伙伴能够构建专用的 AI 基础架构。”

从技术层面来看,NVLink Fusion 的意义非凡。它突破了以往硬件连接的局限性,通过开放的技术架构,允许合作伙伴根据不同应用场景进行定制化开发。企业在构建半定制化 AI 基础设施时,能够实现 GPU、存储和网络资源的无缝协同,不仅缩短部署时间,还能降低整体成本。无论是在云服务、边缘计算,还是行业专用 AI 平台等快速发展的领域,NVLink Fusion 都将发挥重要作用,为行业注入强大的技术驱动力。